模型规模与架构演进

参数规模增长趋势

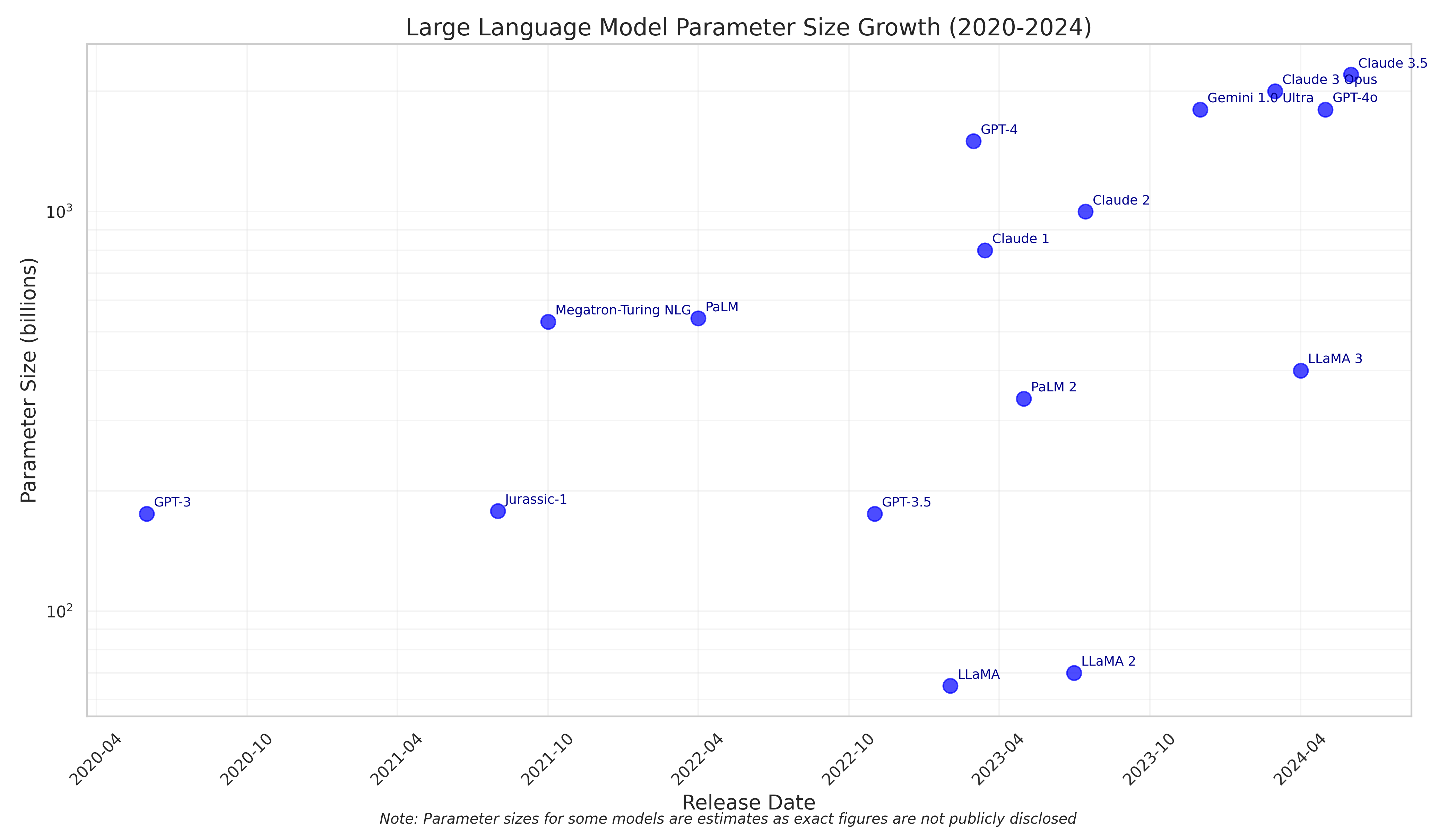

从2020年GPT-3的1750亿参数到2024年Claude 3.5的估计2200亿参数,大型语言模型的参数规模总体呈现增长趋势,但增长速度在2023-2024年间有所放缓。

图1:大型语言模型参数规模增长趋势(2020-2024)

如上图所示,模型参数规模的增长可分为三个阶段:

- 快速增长期(2020-2022年初):从GPT-3到Megatron-Turing NLG,参数规模增长迅速,几乎呈指数级增长。

- 高位波动期(2022-2023年):GPT-4和Claude系列模型的参数规模达到新高度,但增长曲线开始趋于平缓。

- 结构优化期(2023年末-2025年初):模型发展重点从单纯追求参数规模转向架构优化和训练方法创新,如GPT-4o和Claude 3.5系列。

值得注意的是,参数规模并非衡量模型性能的唯一指标。2024年的研究表明,Scaling Law(认为模型的性能同计算量、模型参数量、数据大小成幂律关系)开始受到挑战,模型架构优化和训练数据质量对性能的影响日益凸显。

架构创新

2022-2025年间,模型架构创新主要体现在以下方面:

多模态架构

从纯文本模型向能处理文本、图像、音频等多种模态的统一架构发展,如GPT-4o和Claude 3系列。

推理增强架构

OpenAI的o1和o3模型引入"深思熟虑"式内部思维链,显著提升了复杂推理能力。

效率优化

FlashAttention等技术革新了语言模型内存利用方式,大幅提升训练和推理效率。

量化技术

模型量化技术的进步使大型模型能够在更广泛的硬件上高效运行,如Meta的Llama 3.2量化版本。